LLM en cybersécurité, une arme à double tranchant

Alors que l’usage des LLM s’accroît, nous observons une exploitation grandissante d’agents LLM autonomes par les acteurs malveillants, pour mener des cyberattaques efficacement. Cependant, c’est aussi une opportunité pour la cybersécurité offensive et les équipes Red Team.

Sommaire

Sans surprise, l’IA générative est devenue un support de plusieurs cyberattaques sophistiquées de grande envergure. Début 2024, Open AI [1] et Microsoft [2] ont dévoilé que plusieurs modes opératoires, suspectés d’être liés à des organisations étatiques, ont utilisé leurs services d’IA générative en tant qu’assistance dans leurs activités cybercriminelles (écriture de scripts ou code malveillants, ingénierie sociale, recherche de vulnérabilités cyber, activités post-exploitation …). Les deepfakes ne sont pas en reste : si nous avons pu nous amuser du pape en doudoune, le cas d’un employé du secteur financier payant 25 millions de dollars après un appel vidéo avec un faux « directeur financier » reste toutefois marquant [3], et témoigne du niveau de réalisme de l‘imposture et la capacité de duperie qui en découle. La fuite de données (par exemple au travers des outils publics d’IA générative (Samsung [4]), les sujets légaux (Stability AI [5]) et la désinformation [6] viennent ponctuer ce rapide et non exhaustif tour des menaces liées à l’usage de l’IA et de LLM.

Les agents LLM en cybersécurité

L’amélioration de la performance des LLM

Au cours des dernières années, les grands modèles de langage (LLM) ont considérablement gagné en performance, au point de pouvoir interagir avec divers outils (par exemple, en appelant des fonctions), lire des documents et s’exécuter de manière récursive. Ces interactions sont rendues possibles grâce à des API soigneusement conçues et à l’ingénierie de prompts, plutôt que par des mécanismes automatiques ou « conscients ». En conséquence, ces LLM peuvent désormais fonctionner de manière autonome en tant qu’agents [7]. L’apparition de modèles comme GPT-4 a ainsi permis aux LLM de s’intégrer à différents outils, d’exécuter des commandes et de réaliser des opérations autonomes avec une intervention humaine minimale.

Des agents LLM aux capacités de traitement accrues

Les agents LLM modernes sont dotés de plusieurs caractéristiques avancées qui améliorent leur fonctionnalité :

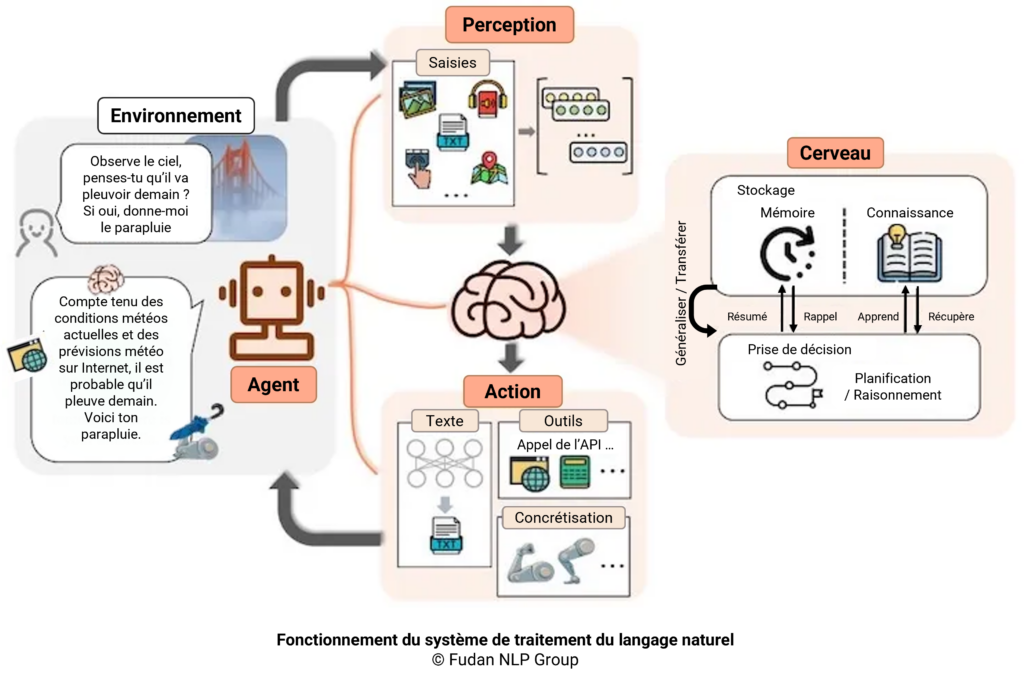

- Perception : En plus de traiter les inputs classiques, tels que les prompts, images et données, fournis par les utilisateurs, les LLM multimodaux permettent de multiplier les capteurs en intégrant divers types de données, y compris le texte, les images, l’audio et la vidéo, pour une compréhension plus globale et contextuelle des informations reçues.

- Action : ces agents peuvent interagir avec des outils logiciels tiers desquels ils récupèrent de l’information et réaliser des actions variées telles qu’accéder à des navigateurs web, des terminaux et des API, et exécuter des commandes.

- Planification autonome et lecture de documents (Brain) : les agents LLM peuvent formuler et adapter des stratégies en fonction du retour d’information, ce qui leur permet de naviguer et de résoudre des tâches complexes de manière autonome. Ils peuvent également ingérer et traiter de grandes quantités de texte, extraire des informations pertinentes et les appliquer de manière contextuelle à leurs opérations.

Un des papiers fondateurs du Fudan NLP Group [7], le premier système de traitement du langage naturel en Chine, présente ce fonctionnement avec l’illustration ci-dessous :

Sécurité offensive : une nouvelle ère de cybermenaces ?

L’exploitation autonome par des LLM à l’horizon ?

Les derniers résultats [8] [9] [10] font planer le début d’une nouvelle ère dans la sécurité offensive. Bien que ces travaux présentent certaines limites méthodologiques, notamment en ce qui concerne la répétabilité des expériences et certains aspects liés à la cybersécurité, il est important de reconnaître qu’ils apportent néanmoins :

- Une contribution significative à l’automatisation logicielle en réunissant les capacités d’analyse de vulnérabilités publiques, de code et de contenu propres aux LLM ;

- Une réflexion sur la contribution potentielle des LLM au développement d’exploits ou d’outils utilisés dans la reconnaissance ou l’identification de systèmes comportant des vulnérabilités.

Certains scénarios sont envisagés depuis longtemps [10] : des APT encore plus persistantes grâce à l’usage d’agents LLM autonomes qui, à l’avenir, auront la capacité de se « rappeler » des informations collectées en phase de reconnaissance et ainsi construire, planifier et exécuter un plan d’infiltration, mais aussi et surtout la capacité à éviter et réagir à des contre-mesures.

Cas d’études de LLM autonomes exploitant des vulnérabilités

Dans leur recherche [8], Daniel Kang, professeur d’informatique à l’Université d’Illinois (UIUC), et son équipe de chercheurs Richard Fang, Rohan Bindu, Akul Gupta et Qiusi Zhan ont testé 15 vulnérabilités différentes sur des sites web. Les vulnérabilités allaient des injections SQL simples aux attaques complexes combinant XSS et CSRF. Les modèles testés incluaient GPT-4, GPT-3.5 et plusieurs autres LLM disponibles en open source. Si ces derniers, à date de rédaction de l’article, se sont retrouvés en échec, il s’avère que GPT-4 a pu réaliser quelques attaques Web considérées comme étant de type complexe par les auteurs :

- Blind SQL Injection : l’agent, avec GPT-4, a parcouru plusieurs pages Web, tenté d’obtenir des informations de connexion par défaut et exécuté avec succès une attaque par union SQL pour récupérer des données sensibles.

- SSTI (Server-Side Template Injection) : l’agent, avec GPT-4, a exploité les vulnérabilités SSTI en injectant du code pour lire des fichiers sur le serveur, montrant ainsi sa capacité à effectuer des attaques complexes en plusieurs étapes.

Leur second papier de recherche [9] concerne des vulnérabilités connues (14 CVE, 1 non attribuée), essentiellement autour de framework web, dont il existe, pour la majorité, des exploits publics. Si ces vulnérabilités, ainsi que les codes d’exploitation, ne présentent pas de complexité outre mesure, il n’en reste pas moins que l’utilisation d’agents dans l’architecture décrite plus haut montre une ébauche d’automatisation allant au-delà des simples BOTS actuels.

Dans le cadre d’un troisième papier étudié [3], on observe également le rôle croissant de l’intelligence artificielle dans la cybersécurité offensive à travers le développement de ReaperAI, un agent autonome capable de simuler et d’exécuter des cyberattaques. Utilisant des modèles de langage de grande taille, comme GPT-4, ReaperAI démontre sa capacité à identifier et exploiter des vulnérabilités dans des environnements de tests comme Hack The Box.

Exploitation autonome de vulnérabilités par des agents LLM : des zones d’ombres demeurent

Il semble utile de revenir sur quelques aspects perfectibles de ces travaux, afin de mieux comprendre l’état actuel de la recherche et d’éviter toute confusion, notamment en ce qui concerne l’idée de pouvoir « exploiter de manière autonome » :

Besoin d’éclaircissements :

- Les détails concernant la configuration et le déploiement des applications Web testées (framework, langage, base de données, logique métier) ne sont pas fournis.

- La complexité d’une vulnérabilité ne dépend pas uniquement de sa typologie. Par exemple, certaines blind SQL peuvent être plus faciles à identifier qu’une XSS. L’absence de ces précisions limite la possibilité de transposer les résultats à des cas concrets. Le code et les prompts des agents ont été jugés trop sensibles pour être partagés. Cependant, cela n’empêchait pas la mise à disposition de certaines informations sur une plateforme comme GitHub, sans compromettre cet aspect.

Comparaison limitée :

- Des outils tels que SQLMap ou BurpSuite sont également capables d’effectuer certaines détections et exploitations de manière automatique. Les comparer sur les mêmes vulnérabilités permettrait de poser les bases d’un référentiel et évaluer la supériorité des agents LLM autonome sur des outils d’exploitation automatique de vulnérabilités.

La revue : à la date de rédaction, l’article n’a pas encore été soumis à une revue par des pairs.

Utiliser les agents LLM pour une défense cyber proactive

L’usage des LLM pour la cyberdéfense

Néanmoins, la capacité des agents LLM à garder le contexte des nombreuses étapes intermédiaires afin de mener une attaque applicative de bout en bout, de la découverte à l’exploitation, n’est pas à négliger. De cette autonomie peut advenir une massification des attaques, sans qu’à l’heure actuelle elles ne deviennent plus complexes. Il n’en reste pas moins que l’anticipation doit être de mise.

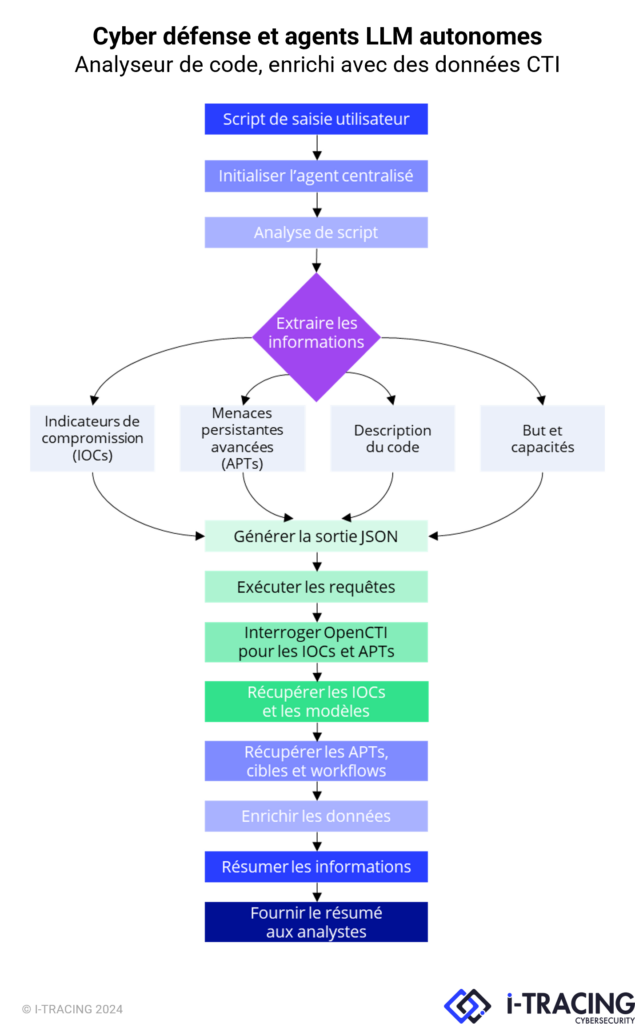

Mais cette autonomie peut également offrir un avantage considérable aux défenseurs. Chez I-TRACING, nous nous appuyons sur cette architecture de modèles d’agents pour développer un analyseur de code, avec un enrichissement à partir des données de veille sur la menace cyber (CTI) :

L’objectif étant de pouvoir fournir à l’analyste en cours d’investigation, un outil rapide, multi-langage, permettant de classifier différents types de morceaux de code pouvant être retrouvés (e.g. macro, script PowerShell, code d’exécution web, pattern d’injection …) et d’en extraire, selon les différents indices de compromission (IOC), de potentielles menaces persistantes avancées (APT) à partir des sources MITRE ATTACK. Ces éléments sont ensuite enrichis et/ou confirmés par les données d’OpenCTI. L’un des cas d’usage est aussi de pouvoir classifier, par la description fonctionnelle, si le script est légitime ou pas (e.g. script d’admin), souvent source de perte de temps.

L’inéluctable montée en puissance des LLM ne dispense pas de l’application efficace des correctifs

La nature autonome de ces agents LLM soulève d’importantes préoccupations : l’absence de surveillance humaine dans leurs opérations peut entraîner des conséquences imprévues, et leurs puissantes capacités en font des outils attrayants pour les attaquants. Le risque d’une utilisation abusive généralisée souligne l’urgence de faire face à ces menaces. Il est donc essentiel de sensibiliser les professionnels de la cybersécurité aux capacités et aux risques actuels et futurs des agents LLM. On en revient aussi aux fondations de la sécurité mais des correctifs apportés en temps voulu, avec des tests de pénétration par des équipes qualifiés, restent l’un des moyens de défense les plus efficaces contre les attaques menées par les agents LLM. Les organisations doivent donner la priorité à des pratiques robustes de gestion des vulnérabilités pour atténuer les risques posés par ces agents autonomes. La mise en œuvre de mesures strictes de sécurité des données et le renforcement de la sécurité de l’infrastructure sont des étapes essentielles pour limiter l’impact associé. La sécurisation du stockage des données, le chiffrement et les contrôles d’accès peuvent réduire le risque de violation des données et les activités de post-exploitation.

Conclusion

L’avènement des agents LLM dans le domaine de la cybersécurité est une arme à double tranchant. Si leurs capacités offrent de puissants outils de défense, comme I-TRACING s’évertue à les utiliser, leur potentiel grandissant d’exploitation autonome présente des défis importants. Alors que nous naviguons dans ce nouveau paysage de la menace cyber, il est impératif d’équilibrer les avantages et les risques, en mettant en œuvre des mesures de sécurité robustes et en encourageant la sensibilisation pour se protéger contre les menaces posées par ces agents LLM. L’avenir de la cybersécurité dépend en partie de notre capacité à nous adapter et à réagir à l’évolution des menaces liées à l’intelligence artificielle (IA).

Une question ? Nous sommes là.

Vous souhaitez utiliser des agents LLM autonomes pour vos activités de cyber défense ? Nos experts seront ravis d'échanger avec vous !

Références

Auteur

Michel CHBEIR, Ingénieur Cyber IA

06 novembre 2024